En el post de ayer os hablé de la encapsulación molecular y de un artículo publicado recientemente de ese campo (aquí). Pero también existe la microencapsulación : un proceso en el que pequeñas partículas o gotitas se rodean por un revestimiento formando así pequeñas capsulas de múltiples propiedades (microcápsulas).

En general se utiliza para incorporar ingredientes alimentarios, enzimas, células u otros materiales en una escala micrométrica. La microencapsulación también se utiliza para encerrar sólidos, líquidos o gases en un revestimiento formado por una películas soluble, dura o blanda, con el fin de reducir la frecuencia de dosificación y evitar la degradación de los productos farmacéuticos. En la foto podéis ver un ejemplo de microencapsulación (para explicación clicad la foto).

Ejemplo de microencapsulación

Los lipidos y los polímeros como el alginato son algunos de los materiales que se suele utilizar para atrapar el material de interés en el interior. Otros materiales son: etilcelulosa, alcohol de polivinilo, gelatina, alginato sódico.

Como ya he comentado, uno de los materiales que se suele encapsular en microcápsulas son las enzimas, moléculas de naturaleza proteica que catalizan reacciones químicas. Estas, las enzimas, son utilizadas comercialmente, por ejemplo, en la síntesis de antibióticos y productos domésticos de limpieza. Además, son ampliamente utilizadas en diversos procesos industriales, como la fabricación de alimentos, destinción de vaqueros o producción de biocombustibles.

Mediante evolución dirigida, una técnica utilizada en biotecnología e ingeniería de proteínas que imita el proceso de la selección natural para generar y seleccionar variantes de proteínas de interés industrial, se puede producir enzimas comerciales con mejor actividad catalítica e incluso proteínas terapéuticas con una selectividad refinada.

La evolución dirigida imita la evolución biológica mediante la mutación de biomoléculas, la selección de mutantes que mejor se adapten al perfil de actividad deseado, y repitiendo el proceso varias veces, optimizando así.

Florian Hollfelder de la Universidad de Cambridge y sus colegas han desarrollado un método que podría hacer la evolución dirigida más accesible y permitir la deteccción de un mayor número de variantes y lo utilizaron para hacer una fosfotriesterasa 20 veces más rápida en menos de una hora.

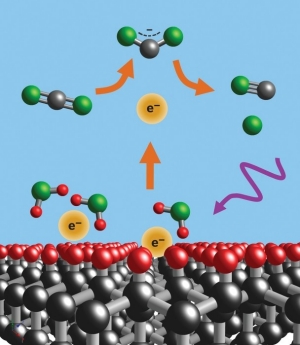

El método utiliza la microfluídica para hacer perlas de gel con recubrimiento (Gel-Shell Breads, GSBs), que encapsulan biomoléculas en evolución y las secuencias de ADN que las codifican, y células activas por fluorescencia (FACS) para seleccionar las variantes más activas.

Generador de gotas

Las bacterias están modificadas genéticamente para albergar un plásmido que codifica una versión modificada del gen para que la enzima sea mejorada. Un generador de gotas de microfluidos (ver foto de arriba) incorpora plásmidos y enzimas expresadas por bacterias individuales en gotas que contienen un gel-líquido. El sustrato de la enzima se modificó, previamente, de modo que la reacción enzimática produce un producto fluorescente y después de la reacción enzima-sustrato, el gel se solidifica por enfriamiento, girando las gotitas. A continuación, Las perlas resultantes del enfriamiento de las gotitas se recubren con capas de polielectrolitos, formando GSBs que contienen la enzima, el ADN que lo codifica y el producto de reacción fluorescente.

Explicación de la foto:

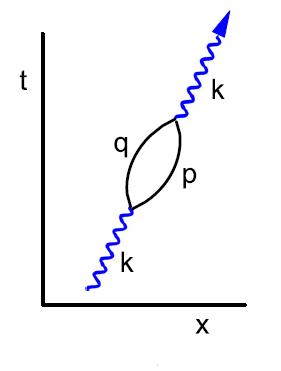

a) La formación de GSBs: las gotitas de emulsión que albergan agarosa y un polianión (alginato) son producidas por el generador de emulsión. Después de enfriarse el gel de agarosa la emulsión monodispersa se mezcla con un exceso de emulsión polidispersa que contiene un policatiñon (Poli(allyl-amine hidrocloride), PAH) y se vortea para asegurarse la mezcla de las dos emulsiones. Seguidamente se añade perfluorooctanol (PFO, un surfactante débil) y se vortea de nuevo. El PFO provoca la desintegracion de la emulsión y el alginato que estaba contenido dentro del compartimento de la gotita original (y el cordón de agarosa resultante) se difunde hacia fuera en dirección opuesta a la perla de agarosa y como consecuencia el polielectrolito recubre la perla.

b) La automatización y la producción en continuo se hace en una secuencia de tres chip de microfluidos juntos: las emulsiones monodispersas que contienen agarosa y alginato se produce en el promer generador de emulsión. El tubo de la toma se enfrís en hielo para gelificar la agarosa antes de entrar en el segundo chip donde se mezcla con una segunda emulsión, polidispersa, que contiene el policatión. Posteriormente, la mezcla se añade a una corriente de PFO. En la salida, las dos fases se separan.

Las enzimas con más actividad producen más fluorencencia (FACS) por lo que son seleccionadas. Los plásmidos de los GSBs seleccionados se extraen y se introducen en las siguientes rondas de evolución dirigida, hasta obtener una enzima optimizada.

Fuentes:

El efecto Marangoni (también llamado efecto Gibbs-Marangoni) es la transferencia de materia en una interfase entre dos fluidos debido a un gradiente de tensión superficial. Una consecuencia de este efecto se puede ver en el fondo de un vaso de whisky usado vacío. Donde se puede contemplar los patrones complejos de flujos circulantes que dipositan diversos compuestos sólidos dentro del whisky con patrones peculiares.

El efecto Marangoni (también llamado efecto Gibbs-Marangoni) es la transferencia de materia en una interfase entre dos fluidos debido a un gradiente de tensión superficial. Una consecuencia de este efecto se puede ver en el fondo de un vaso de whisky usado vacío. Donde se puede contemplar los patrones complejos de flujos circulantes que dipositan diversos compuestos sólidos dentro del whisky con patrones peculiares.

En 1875

En 1875

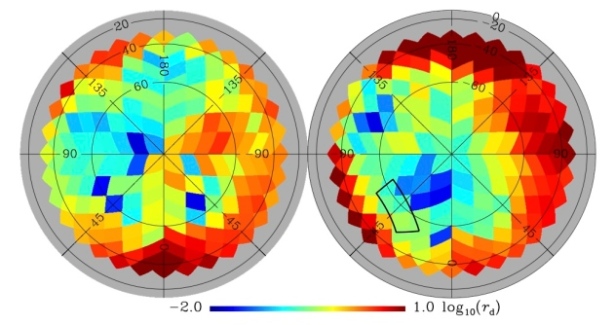

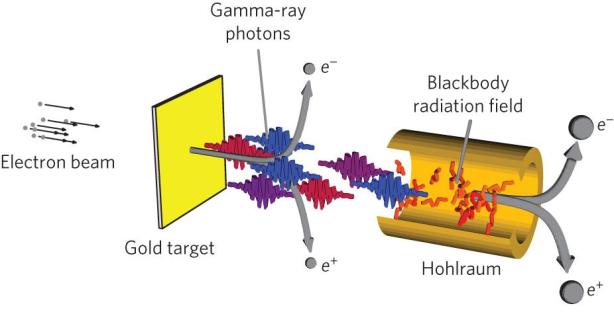

A mediados de marzo científicos de EE.UU detectaron la primera evidencia de las ondas gravitacionales primordiales. Es decir, las ondulaciones que la inflacción generó en eel espacio hace 13,8 mil millones de años cuando el Universo empezó a expandirse y que podrían ser la primera evidencia directa de la inflacción cósmica ( momento histórico en el que, en menos de un segundo, el Universo pasó de ser un punto diminuto a convertirse en una inmensidad – Teoria del Big Bang-).

A mediados de marzo científicos de EE.UU detectaron la primera evidencia de las ondas gravitacionales primordiales. Es decir, las ondulaciones que la inflacción generó en eel espacio hace 13,8 mil millones de años cuando el Universo empezó a expandirse y que podrían ser la primera evidencia directa de la inflacción cósmica ( momento histórico en el que, en menos de un segundo, el Universo pasó de ser un punto diminuto a convertirse en una inmensidad – Teoria del Big Bang-). Recientemente se han publicados los datos de

Recientemente se han publicados los datos de